AI打破脑机接口延迟壁垒:瘫痪者“开口”仅需一秒

4月11日消息,加州大学伯克利分校与旧金山分校的研究团队宣布在脑机接口(BCI)领域取得突破,他们成功开发出一种技术,帮助重度瘫痪患者恢复自然语音表达。该技术利用人工智能(AI)模型,将大脑信号实时转化为可听语音,解决传统语音神经假体延迟问题。

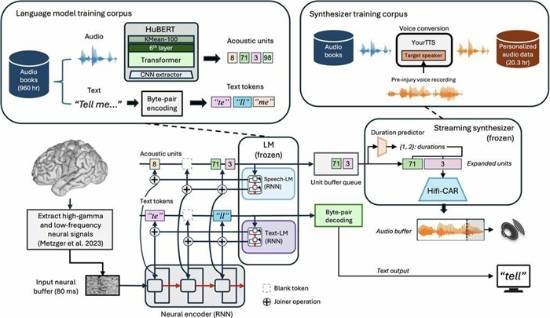

加州大学伯克利分校与旧金山分校的研究团队开发了一种创新方法,通过捕捉大脑运动皮层信号,利用AI算法实时解码并生成语音。

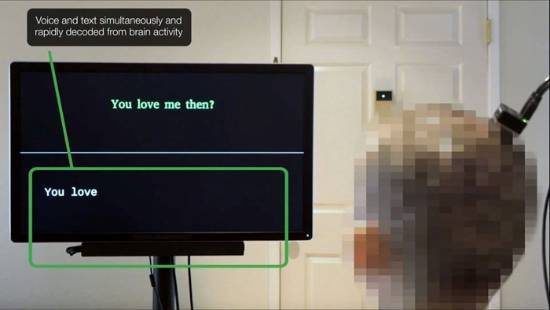

研究共同负责人、伯克利分校电气工程与计算机科学系助理教授Gopala Anumanchipalli表示,这种“直播”(streaming)方法借鉴了类似Alexa和Siri的语音解码技术,能显著缩短从大脑意图到语音输出的时间。实验中,患者Ann无需发声,仅通过“默想”句子即可生成接近自然的语音。

新技术的核心在于解决传统BCI语音解码的延迟问题,以往技术单句解码需约8秒,而新方法能在患者产生说话意图后1秒内输出首个音节。

研究共同第一作者、伯克利分校博士生Kaylo Littlejohn介绍,团队通过AI预训练文本转语音模型,模拟患者受伤前的声音,让输出更具个性化。实验还验证了该技术对多种脑信号采集设备(如微电极阵列和面部肌电传感器)的兼容性,并展示了其泛化能力,即使在未包含在训练数据中的单词上也能准确解码。

据患者Ann反馈,新方法让她感到更强的控制感和自我表达能力。研究团队计划继续优化算法,增强语音的自然度和情感表达,同时探索如何将技术应用于更广泛的临床场景。

免责声明:本文为转载,非本网原创内容,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。

如有疑问请发送邮件至:goldenhorseconnect@gmail.com

- 谢孟伟称拍小兵张嘎一分钱没要 没改变家里经济情况2024-07-05

- 老麦克模拟器:模拟游戏《凶案现场清洁工》8.14发售2024-08-04

- 金铲铲之战香水宝石悠米要怎么肝2024-08-12

- 黑神话悟空三冬虫全地图收集位置2024-08-22

- 星球重启拳王小熊属性介绍2024-08-22

- IGN中国分享:《黑神话》"小西天"全Boss战演示2024-08-27

- SE修复《最终幻想16》PC试玩版 体验大幅提升2024-08-27

- 游民星空专访BLG中单Knight:“我《黑神话》刚到第二章”2024-08-31

- 晨报|曝NS2将有双屏体验 R星欲为GTA6低价买断歌曲2024-09-08

- 郭帆谈年轻人躺平:看不到奋斗的路径和结果2024-09-15