佐治亚理工学院开发新框架 为模仿学习创建以自我为中心的演示

模仿学习是教机器人完成洗碗或准备食物等手动任务的最有前途的方法之一。端到端模仿学习通常需要对人类完成手动任务的原始视频、图像和/或动作捕捉数据进行深度学习算法的训练。在此训练过程中,算法逐渐学会产生输出动作(即机器人关节运动、轨迹等),使机器人能够成功完成相同的任务。

虽然模仿学习技术可以增强机器人完成复杂物体操作任务的能力,但它们通常不允许机器人在训练数据集中未包含的任务中进行推广。此外,收集各种任务的训练演示可能具有挑战性,需要先进的传感器或设备。

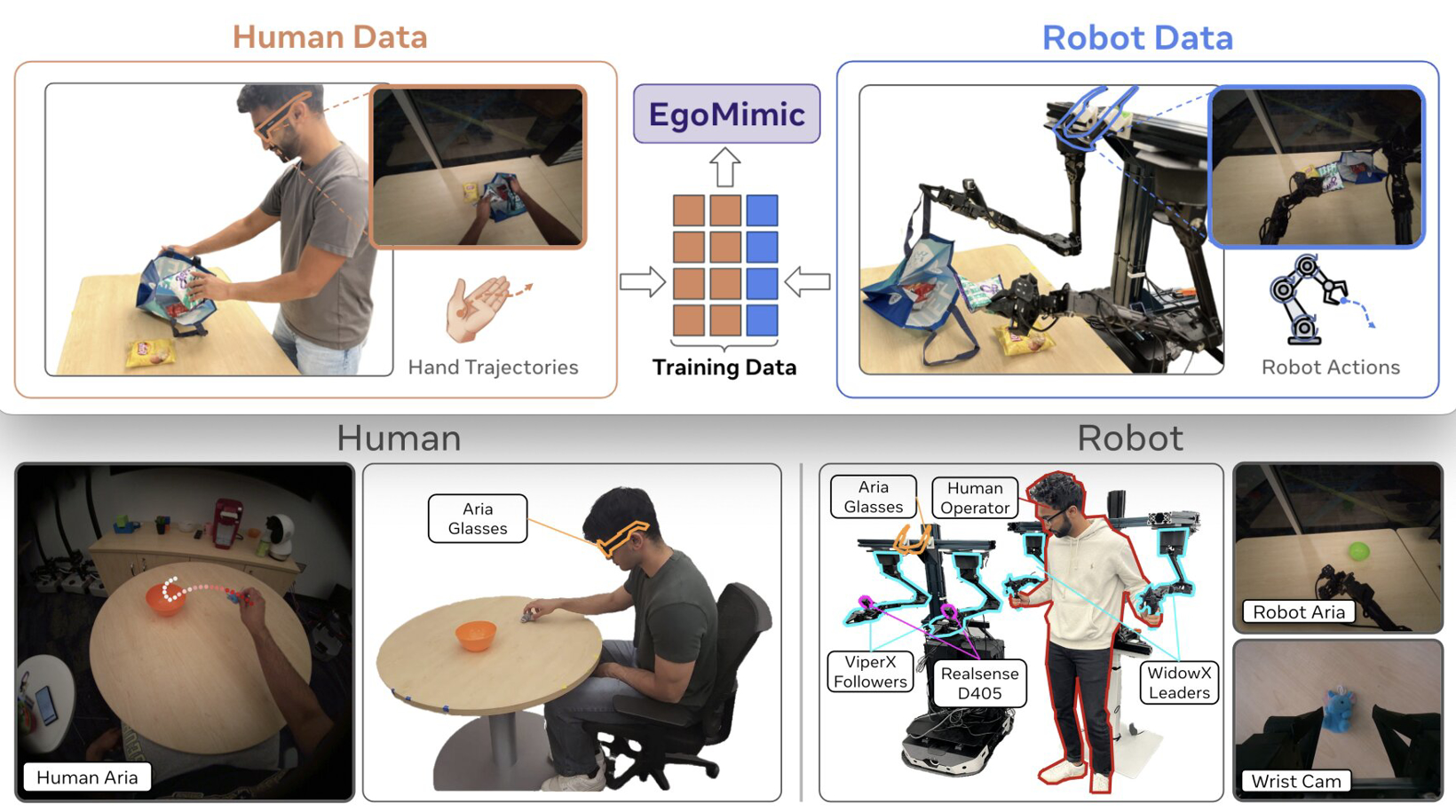

据外媒报道,佐治亚理工学院(Georgia Institute of Technology)的研究人员最近推出新框架EgoMimic,可用于轻松收集更多不同的模仿学习演示数据。该框架已发表在arXiv预印本服务器,提供了一个可扩展的平台,用于从完成任务的人(即自我中心)的角度收集人类完成手动任务的视频演示。

图片来源:佐治亚理工学院

研究人员Simar Kareer、Dhruv Patel及其同事在论文中写道:“我们提出了一个全栈框架EgoMimic,可以通过人类化身数据进行扩展操作,特别是以自我为中心的人类视频与3D手部追踪相结合。”

“EgoMimic通过以下方式实现这一目标:(1)使用符合人体工程学的Project Aria眼镜捕捉人体化身数据的系统,(2)低成本双手操纵器,可最大限度地缩小与人体数据的运动学差距,(3)跨域数据对齐技术,以及(4)模仿学习架构,可对人类和机器人数据进行共同训练。”

EgoMimic框架的第一个组件,即捕捉演示视频的系统,依赖于使用Meta Reality Labs Research创建的可穿戴智能眼镜Project Aria。人类在完成日常手动任务时佩戴这些眼镜,以从他们的视角记录任务。

研究人员用来处理人类完成的相同任务的双手机器人系统由两个集成英特尔RealSense腕式摄像头的Viper X机械臂组成,这两个机械臂又由两个WidowX机械臂控制。值得注意的是,这个双手机器人在完成任务时还“戴上”Aria眼镜,因为这可以最大限度地缩小人类演示者完成任务的镜头与机器人对工作空间的视野之间的差异。

“与之前仅从人类视频中提取高级意图的研究相比,我们的方法将人类和机器人数据平等地视为具身演示数据,并从两个数据源中学习统一的策略,”Kareer、Patel及其同事写道。

研究人员在实验室中进行了一系列实验,以测试所提出的框架。在这个框架中,机器人学会了完成长期的现实世界任务。例如,机器人学会拿起一个小毛绒玩具,把它放在碗里,拿起碗,把玩具倒在桌子上,然后重复这一系列动作40秒。

机器人接受的其他训练任务包括以特定方式折叠T恤和将薯片袋装进购物袋。这些初步实验的结果非常有希望,因为EgoMimic框架在这三个任务上的表现比过去引入的其他最先进的模仿学习技术更好,同时也让机器人能够有效地将学到的技能应用到训练期间没有遇到的任务上。

Kareer、Patel及其同事写道:“EgoMimic在一系列长视界、单臂和双手操作任务上取得了显著进步,超越了最先进的模仿学习方法,并能够推广到全新的场景。最后,我们展示了EgoMimic的良好扩展趋势,其中添加1小时的额外手部数据比添加1小时的额外机器人数据更有价值。”

研究人员使用的数据处理和训练模型的代码可在GitHub上找到。未来,全球机器人专家都可以使用EgoMimic或其改编版本,已提高机器人系统在涉及操作物体的各种日常任务中的性能和通用性。

免责声明:本文为转载,非本网原创内容,不代表本网观点。其原创性以及文中陈述文字和内容未经本站证实,对本文以及其中全部或者部分内容、文字的真实性、完整性、及时性本站不作任何保证或承诺,请读者仅作参考,并请自行核实相关内容。

如有疑问请发送邮件至:goldenhorseconnect@gmail.com

- 佐治亚理工学院开发新框架 为模仿学习创建以自我为中心的演示2024-12-03

- 研究人员开发出高性能高熵富锂层状氧化物阴极 用于锂离子电池2024-12-03

- Seeds丨Flipturn完成1100万美元A轮融资 旨在彻底改变电动汽车车队充电和管理方式2024-12-03

- 日本政府提供支持 电装与富士电机合作开发SiC电动汽车功率半导体2024-12-03

- 通用汽车申请电动汽车串联充电专利2024-12-03

- 哪吒汽车创始人方运舟:2024年哪吒汽车的出口占比预计在30%2024-12-03

- 英超奖杯值多少钱,英超冠军奖杯叫什么名字2024-12-03

- 篮网队史个人得分记录,篮网队历史战绩2024-12-03

- 第42界乒乓球冠军,第42界乒乓球冠军名单2024-12-03

- nba厉害的球员排名,nba厉害的球星都有谁2024-12-03